Más de 30 millones de mexicanos en riesgo por mal estado del agua

El 70% de envases de agua de negocios rellenadores contienen bacterias, según investigaciones del IPN y otras instituciones. Cuáles son los mayores riesgos

Una carta firmada por ejecutivos como Elon Musk advirtieron sobre la necesidad de una pausa en su desarrollo descontrolado debido al "riesgo para la humanidad"

Ciencia y Tecnología29 de marzo de 2023 Redacción Primicia 24

Redacción Primicia 24

Un grupo compuesto por académicos, expertos en inteligencia artificial (IA) y ejecutivos como Elon Musk han emitido una carta abierta pidiendo una pausa de seis meses en el desarrollo de sistemas más avanzados, incluyendo el recién lanzado GPT-4 de OpenAI, citando riesgos potenciales para la sociedad y la humanidad.

A principios de este mes, OpenAI, respaldado por Microsoft, presentó la cuarta versión de su programa de IA, Generative Pre-trained Transformer (GPT), que ha impresionado a los usuarios con sus diversas aplicaciones, desde conversaciones similares a las humanas hasta composiciones de canciones y resúmenes de documentos extensos.

La carta, emitida por el instituto sin fines de lucro Future of Life, ha sido firmada por más de 1.000 personas, incluyendo a Musk, y pide una pausa en el desarrollo avanzado de la IA hasta que expertos independientes desarrollen, implementen y auditen protocolos de seguridad compartidos para dichos diseños. "Los poderosos sistemas de IA deben desarrollarse solo cuando estemos seguros de que sus efectos serán positivos y sus riesgos manejables", afirma la carta.

La carta describe los posibles riesgos para la sociedad y la civilización que conlleva la circulación de sistemas de IA competitivos entre humanos, incluyendo interrupciones económicas y políticas, y pide a los desarrolladores que trabajen con legisladores y autoridades reguladoras para la gobernanza. Entre los firmantes se encuentran el CEO de Stability AI, Emad Mostaque, investigadores de DeepMind, propiedad de Alphabet, y pesos pesados de la IA como Yoshua Bengio, a menudo llamado uno de los "padres de la IA", y Stuart Russell, un pionero en la investigación del campo.

Europol, la fuerza policial de la UE, se unió el lunes a un coro de preocupaciones éticas y legales sobre la IA avanzada, incluyendo ChatGPT, advirtiendo sobre posibles usos indebidos del sistema en intentos de phishing, desinformación y ciberdelincuencia. Mientras tanto, el gobierno del Reino Unido ha dado a conocer propuestas para un marco regulatorio "adaptable" en torno a la IA.

El enfoque del gobierno, descrito en un documento de política publicado el miércoles, dividiría la responsabilidad de gobernar la IA entre sus reguladores de derechos humanos, salud y seguridad y competencia, en lugar de crear un nuevo organismo dedicado a la tecnología.

A pesar de que la empresa fabricante de automóviles de Elon Musk, Tesla, está utilizando la IA para un sistema de piloto automático, él ha expresado sus preocupaciones sobre el desarrollo de la IA.

Desde su lanzamiento el año pasado, ChatGPT de OpenAI ha llevado a los rivales a acelerar el desarrollo de modelos de lenguaje grandes similares y a las empresas a integrar modelos de IA generativa en sus productos. La semana pasada, OpenAI anunció que se había asociado con alrededor de una docena de empresas para incorporar sus servicios en su chatbot, lo que permite a los usuarios de ChatGPT pedir comestibles a través de Instacart o reservar vuelos a través de Expedia.

Aunque el director ejecutivo de OpenAI, Sam Altman, no firmó la carta, un portavoz de Future of Life dijo que "el espíritu es correcto: debemos reducir la velocidad hasta que entendamos mejor las ramificaciones". Sin embargo, algunos críticos han acusado a los firmantes de la carta de exagerar los riesgos de la IA y promover el miedo infundado.

Johanna Björklund, investigadora de IA y profesora asociada en la Universidad de Umeå, argumenta que, en lugar de detener la investigación, los investigadores de IA deberían estar sujetos a mayores requisitos de transparencia. "Si realiza una investigación de IA, debe ser muy transparente sobre cómo lo hace", dijo. En lugar de frenar el progreso de la IA, la transparencia puede ayudar a la sociedad a comprender mejor las posibilidades y los límites de esta tecnología y a trabajar en conjunto para garantizar su uso responsable.

Los sistemas de Inteligencia Artificial (IA) con inteligencia humana-competitiva pueden plantear riesgos profundos para la sociedad y la humanidad, como lo demuestra una extensa investigación y es reconocido por los principales laboratorios de IA. Como se establece en los Principios de IA de Asilomar, ampliamente respaldados, la IA avanzada podría representar un cambio profundo en la historia de la vida en la Tierra, lo cual debe planificarse y administrarse con el cuidado y los recursos correspondientes. Desafortunadamente, este nivel de planificación y gestión no está ocurriendo, a pesar de que en los últimos meses los laboratorios de IA han entrado en una carrera fuera de control para desarrollar e implementar mentes digitales cada vez más poderosas que nadie, ni siquiera sus creadores, pueden entender, predecir o controlar de forma fiable.

Los sistemas de IA contemporáneos ahora se están volviendo competitivos para los humanos en tareas generales y debemos preguntarnos: ¿Deberíamos dejar que las máquinas inunden nuestros canales de información con propaganda y falsedad? ¿Deberíamos automatizar todos los trabajos, incluidos los que nos placen? ¿Deberíamos desarrollar mentes no humanas que eventualmente podrían superarnos en número, ser más inteligentes y reemplazarnos? ¿Deberíamos arriesgarnos a perder el control de nuestra civilización? Tales decisiones no deben delegarse en líderes tecnológicos no elegidos. Los sistemas potentes de IA deben desarrollarse solo una vez que estemos seguros de que sus efectos serán positivos y sus riesgos serán manejables. Esta confianza debe estar bien justificada y aumentar con la magnitud de los efectos potenciales de un sistema. La declaración reciente de la empresa OpenAI con respecto a la inteligencia artificial en general, establece que: “En algún momento, puede ser importante obtener una revisión independiente antes de comenzar a entrenar sistemas futuros, y los esfuerzos más avanzados para acordar limitar la tasa de crecimiento de la computación utilizada para crear nuevos modelos”. Estamos de acuerdo. Ese punto es ahora.

Por lo tanto, hacemos un llamado a todos los laboratorios de IA para que pausen de inmediato durante al menos 6 meses el entrenamiento de los sistemas de IA más potentes como GPT-4. Esta pausa debe ser pública y verificable, e incluir a todos los actores clave. Si tal pausa no se puede promulgar rápidamente, los gobiernos deberían intervenir e instituir una moratoria.

Los laboratorios de IA y los expertos independientes deberían aprovechar esta pausa para desarrollar e implementar mancomunadamente un conjunto de protocolos de seguridad compartidos para el diseño y desarrollo avanzados de IA que son rigurosamente auditados y supervisados por expertos externos independientes. Estos protocolos deben garantizar que los sistemas que se adhieren a ellos sean seguros más allá de toda duda razonable. Esto no significa una pausa en el desarrollo de la IA en general, simplemente un paso atrás de la carrera peligrosa hacia modelos de caja negra impredecibles cada vez más grandes con capacidades emergentes.

La investigación y el desarrollo de IA deben reenfocarse en hacer que los sistemas potentes y de última generación de hoy en día sean más precisos, seguros, interpretables, transparentes, robustos, alineados, confiables y leales.

Paralelamente, los desarrolladores de IA deben trabajar con los legisladores para acelerar drásticamente el desarrollo de sistemas sólidos de gobierno de IA. Estos deben incluir como mínimo: autoridades reguladoras nuevas y capaces dedicadas a la IA; supervisión y seguimiento de sistemas de IA de alta capacidad y grandes conjuntos de capacidad computacional; sistemas de procedencia y marcas de agua para ayudar a distinguir las fugas reales de las sintéticas y rastrear modelos; un sólido ecosistema de auditoría y certificación; responsabilidad por daños causados por IA; financiación pública sólida para la investigación técnica de seguridad de la IA; e instituciones bien dotadas para hacer frente a las dramáticas perturbaciones económicas y políticas (especialmente en la democracia) que provocará la IA.

La humanidad puede disfrutar de un futuro floreciente con la IA. Habiendo tenido éxito en la creación de poderosos sistemas de IA, ahora podemos disfrutar de un “verano de IA” en el que cosechamos las recompensas, diseñamos estos sistemas para el claro beneficio de todos y le damos a la sociedad la oportunidad de adaptarse. La sociedad ha hecho una pausa en otras tecnologías con efectos potencialmente catastróficos en la sociedad. Podemos hacerlo aquí. Disfrutemos de un largo verano de IA, no nos apresuremos a caer sin estar preparados.

El 70% de envases de agua de negocios rellenadores contienen bacterias, según investigaciones del IPN y otras instituciones. Cuáles son los mayores riesgos

Bill Nelson, ex astronauta y administrador de la agencia espacial estadounidense, vino a la Argentina. “Personalmente creo que en el Universo hay vida afuera”

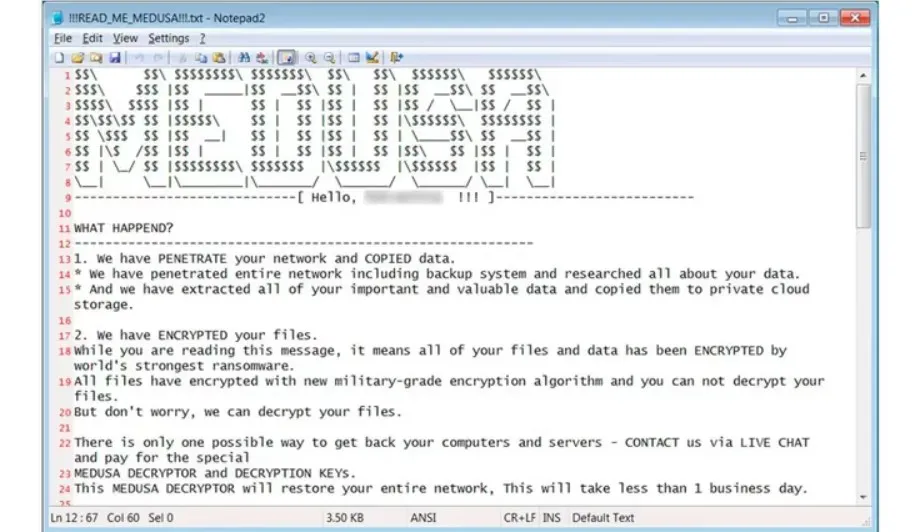

En su blog, el grupo emitió una advertencia dirigida a la CNV, exigiendo una suma de USD 500.000 a cambio de no revelar los datos al público

El economista Lawrence Summers, ex presidente de la Universidad de Harvard, se refirió a la “woke generation”. Cuál es la mirada de la eminencia americana

La web permitió a los estafadores quedarse con 125 millones de dólares haciéndose pasar por representantes de grandes bancos. Qué dijo su creador

Descubre qué es el SEO y cómo puede mejorar la visibilidad de tu sitio web en los motores de búsqueda. Aprende los conceptos básicos del SEO en este artículo

Explorá la vida y el legado de uno de los hombres más influyentes de todos los tiempos. Nikola Tesla revolucionó la historia moderna con sus descubrientos

Con enfoque en America Latina, principalmente en Argentina, Chile, Colombia y México, tendrán cuatro áreas. No requieren conocimientos previos

La plataforma recientemente comprada por Elon Musk, puso en marcha algunos cambios con respecto a las verificaciones. Qué problemas puede trae el cambio

En el corazón del conurbano profundo, bastión del peronismo, el Presidente comenzó la campaña legislativa con una instrucción clara: “Nunca Más kirchnerismo”.

Diputados aprobaron partidas para universidades y salud infantil. Milei analiza vetar la ley y reafirma su política de no ceder ante la demagogia presupuestaria

Boca se hunde entre derrotas y malas decisiones mientras Riquelme convirtió al club en una extensión de su ego y su militancia pero el fútbol cada vez más lejos

La revolución silenciosa del socialismo avanzó sobre el núcleo más sagrado de la sociedad: la familia. ¿Estamos a tiempo de retomar los valores fundamentales?

De la energía a la moda, pasando por las finanzas, Alejandro Betancourt ha construido imperio empresarial que genera admiración en los jovenes venezolanos

El martes, la Cámara de Apelaciones del Segundo Circuito definirá si concede o no la suspensión pedida por el Gobierno para frenar la entrega del 51% de las acciones de YPF. Si Argentina no cumple y es declarada en desacato, se multiplicarían las consecuencias financieras

La fiscal general Pam Bondi anunció que el presidente venezolano es buscado por narcotráfico y vínculos con el crimen organizado. La comparacion con Pablo Escobar

La dieta cetogénica se ha popularizado como un método rápido para bajar de peso, basado en reducir al mínimo los carbohidratos y aumentar el consumo de grasas

Histórico operativo contra el Tren de Aragua en Argentina genera dudas en tribunales: ¿hay pruebas sólidas o un trasfondo político? El caso de José Antonio Lanz Guevara cuestiona la investigación